Sur le sujet de l’intelligence artificielle (IA), l’un des livres les plus connus -et des plus appréciés par la communauté scientifique et intellectuelle- est celui de Nick Bostrom, Superintelligence1. Nick Bostrom est un Suédois, philosophe et physicien de formation, co-fondateur de la World Transhumanist Association, fondateur et directeur de l’Institut pour le futur de l’humanité (Future of Humanity Institute) à l’université d’Oxford. Il s’est fait connaître par plus de 200 articles. L’un d’eux, en 2003, explorait l’hypothèse, considérée par lui comme non farfelue, que nous vivrions dans une simulation informatique2. En 2015, avec Stephen Hawking et Elon Musk, il fut l’un des co-signataires d’une lettre ouverte alertant sur les dangers de l’IA, avec un fort retentissement médiatique.

[La présentation qui suit s’appuie sur la version anglaise du livre, avec citations traduites en français. Cette présentation est suivie de quelques commentaires en italique.]

L’ouvrage.

Le premier chapitre offre au lecteur un historique et un état des lieux. Nick Bostrom y rappelle les étapes du développement des recherches sur l’IA, avec une alternance de phases d’excitation parfois exagérée et de ralentissement. Au-delà de ces vicissitudes, les résultats obtenus par l’IA sont d’ores et déjà spectaculaires. Vers 2015, l’IA égalait ou dépassait les meilleures performances humaines dans la plupart des jeux, hormis les mots croisés, le poker et le jeu de go3. Elle permet de rapides progrès dans de nombreux domaines : optimisation des déplacements, diagnostics médicaux, conception de robots, traduction automatique, reconnaissance faciale ou de la parole, aide à la formulation des preuves mathématiques et à la résolution d’équations, applications militaires et économiques, etc4. Les spécialistes de l’IA ne doutent pas que celle-ci doive dépasser les humains dans la plupart de leurs domaines d’activité, et ce, dans un délai assez court, même s’ils divergent sur la date d’occurrence : parmi eux, en 2016, la médiane des répondants aux enquêtes voyait ce dépassement se produire vers 2075, avec une probabilité de 90 %.

Le chapitre 2 dresse un panorama des chemins possibles vers la super intelligence. L’IA est l’un de ces chemins, mais ce n’est pas le seul. Cinq voies sont passées en revue :

Voie 1 *Concernant l’IA, Nick Bostrom discute la question de la faisabilité d’une super-IA égalant ou dépassant les capacités humaines. Deux arguments sont en faveur de cela. Premièrement, le fait que l’évolution est déjà parvenue à produire l’intelligence humaine. Or, la technologie humaine est déjà très supérieure à l’évolution dans divers domaines. Il est légitime de supposer que cela sera aussi le cas pour la production de l’intelligence et que, dès lors, il faudra beaucoup moins de temps pour reproduire artificiellement celle-ci que ce ne fut le cas la première fois.

Bostrom reconnaît que la capacité informatique nécessaire pour reproduire tout le processus de l’évolution ayant conduit au cerveau humain dépasse encore de nombreux ordres de grandeur5 celle dont nous disposons aujourd’hui. Toutefois -c’est le second argument-, nous avons un moyen de tourner cette difficulté puisque nous disposons d’un modèle : le cerveau humain lui-même. Il suffirait alors de reproduire artificiellement le fonctionnement de notre cerveau. Cela conduit à examiner une deuxième voie vers la super intelligence : l’émulation informatique du cerveau.

Voie 2 *L’émulation complète du cerveau consiste à produire un logiciel intelligent en scannant et en modélisant précisément la structure computationnelle d’un cerveau biologique. Nick Bostrom discute des moyens nécessaires pour y parvenir. Dans une étude publiée en 2008, il envisageait que les conditions de possibilité de l’émulation du cerveau pourraient être réunies vers le milieu du présent siècle, avec une forte marge d’incertitude. Mais à l’heure actuelle, reconnaît-il, « aucun cerveau n’a déjà été émulé », même celui d’un ver transparent de 1 mm de longueur ne comptant que 302 neurones. Une fois qu’un petit cerveau aurait été émulé, des progrès plus rapides pourraient se produire vers l’émulation du cerveau humain lui-même. Une fois ce niveau atteint, il ne serait sans doute guère plus difficile d’émuler des super-cerveaux.

Voie 3 *La voie de l’amélioration biologique des cerveaux actuels est moins révolutionnaire et moins hypothétique. Bostrom ne voit à cela aucune difficulté technique majeure, puisque nous disposons déjà des outils nécessaires : manipulations génétiques, sélection des embryons et des cellules-souches, clonage reproductif. Il lui semble à ce propos qu’une grande marge de progrès est disponible : « Loin d’être la plus brillante espèce biologique possible, nous sommes probablement à considérer comme la plus stupide espèce possible capable de parvenir à une civilisation technologique ».

Une limite toutefois : l’amélioration biologique n’est pas susceptible de produire des progrès de l’intelligence très substantiels dans un court délai. Même avec des techniques sophistiquées telle que la sélection itérative in vitro des embryons, il semble difficile d’espérer, à l’horizon d’un siècle ou deux, plus qu’un gain de 100 à 300 points de QI -ce qui ne serait déjà pas mal, en produisant une humanité où l’individu moyen dépasserait largement les capacités intellectuelles d’Einstein.

*La Voie 4* est celle des interfaces cerveau-ordinateur. Par diverses techniques, on transformerait les êtres humains actuels en des hommes augmentés, dont les cerveaux seraient connectés à des ordinateurs développant considérablement leur potentiel. C’est le modèle du cyborg bien connu des lecteurs de science-fiction. Nick Bostrom croit peu à cette voie qu’il juge trop complexe et risquée par rapport aux gains d’intelligence à espérer -même s’il reconnaît la valeur de certaines avancées techniques.

*Voie 5* Reste la voie de la super intelligence collective, résultant de la mise en réseau et de la coopération des individus au sein d’organisations humaines sans cesse rendues plus performantes. Comme pour l’amélioration biologique des cerveaux, les techniques sont d’ores et déjà disponibles, mais avec des impacts encore plus limités (pas ou très peu d’amélioration individuelle de l’intelligence).

Le chapitre 3 traite des trois formes de la super intelligence : celle qui va plus vite que l’esprit humain ; celle qui intègre un très grand nombre d’intelligences inférieures ; celle qui, sans être nécessairement plus rapide que l’esprit humain, lui est qualitativement supérieure. Pour Nick Bostrom, sur ces trois points, le potentiel des machines -les ordinateurs- est bien supérieur à celui des substrats biologiques -les cerveaux humains.

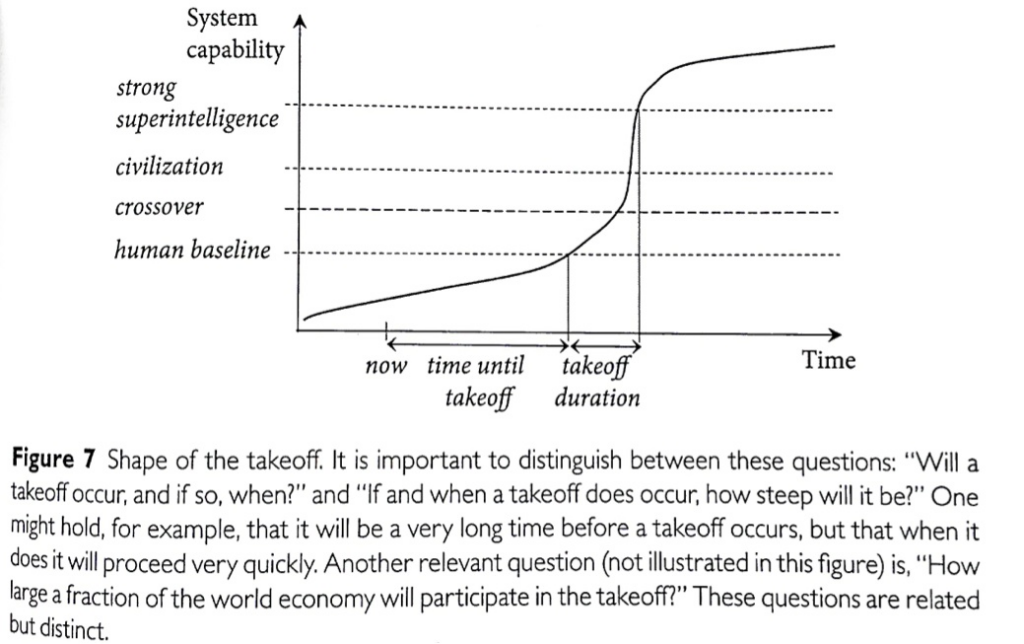

Au chapitre 4, Bostrom explore la question de la dynamique de l’amélioration de l’IA et de la transition vers une super-IA. Selon lui, après une lente croissance initiale de l’IA, obtenue principalement à partir de ressources externes (programmeurs et leur communauté mondiale), viendra probablement une période de développement exponentiel, auto-entretenu par l’IA elle-même, lorsqu’elle aura franchi un certain seuil. C’est seulement plus tard que cette croissance se ralentirait, du fait, notamment, des inévitables limites physiques de l’IA. L’évolution dans le temps prendrait donc l’aspect d’une courbe logistique (figure ci-après extraite du livre), ce qui est une hypothèse assez classique.

Aux chapitres 5 et 6, Nick Bostrom poursuit son exploration du futur. Une super-IA, si son évolution est suffisamment rapide, a de bonnes chances d’être seule à apparaître. Cette super-IA « singleton », sans concurrents -au moins sur notre planète-, aurait des capacités suffisantes pour, tout d’abord, être durable, si elle est suffisamment « avisée », et ensuite, mettre en œuvre ses super-compétences pour maximiser sa fonction d’utilité, par exemple en colonisant la Terre puis l’espace tout entier. Bostrom passe en revue divers scénarios de prise de contrôle par la super-IA, par exemple via des machines de Von Neumann (Von Neumann probes), vaisseaux spatiaux capables d’auto-réplication. Ce processus peut avoir pour conséquence, intentionnelle ou non, de faire disparaître la vie sur terre et l’humanité.

Les chapitres 7 et 8 tentent, respectivement :

*de définir ce que pourraient être les buts ou la volonté d’une super-IA ; Bostrom semble conclure qu’il est difficile d’en savoir grand-chose : « Nous avons trouvé que le lien entre l’intelligence et les valeurs ultimes est très relâché » ;

*de répondre à la question : « l’issue est-elle fatale ? » ; quoique incomplète, la revue par Nick Bostrom des menaces potentielles de la super-IA le conduit à ne pas être très rassuré : « nous en avons vu assez pour conclure que les scénarios dans lesquels une IA acquiert un avantage décisif sont à considérer avec beaucoup de préoccupation ».

Les chapitres 9 et 10 traitent du problème du contrôle de l’IA. Bostrom y passe en revue les méthodes, puis les systèmes de contrôle. S’agissant des méthodes de contrôle, il distingue :

*celles qui visent à limiter ce que peuvent faire les IA : confinement physique ou informationnel ; incitations à se comporter conformément aux intérêts humains ; bridage des capacités du matériel (vitesse de fonctionnement, taille mémoire) ; détecteurs d’anomalies permettant une mise à l’arrêt ;

*celles qui visent à configurer ce que les IA veulent faire, en fixant des objectifs et normes spécifiques directes, ou un cadre normatif indirect, ou en limitant les objectifs à un niveau très modeste, ou enfin en sélectionnant, pour développer leur intelligence, les IA qui ont fait la preuve de motivations bien disposées à notre égard.

La conclusion n’est pas bien rassurante : « Chaque méthode de contrôle a des vulnérabilités potentielles et présente différents degrés de difficulté dans sa mise en œuvre ». Et il en va de même pour les systèmes pouvant combiner certaines de ces méthodes. Une conclusion pas inattendue pour ceux qui se souviennent de la lutte entre l’ordinateur HAL et les astronautes dans 2001 de Kubrick.

L’hypothèse d’une pluralité de super-IA, bien que jugée a priori moins probable, est examinée au chapitre 11. Une société d’IA en concurrence serait-elle plus contrôlable ou moins dangereuse qu’une super-IA unique nous faisant face ? Nick Bostrom semble penser, au contraire, que cela ne ferait qu’ajouter des risques liés aux défauts de coordination entre ces IA.

Au chapitre 12, Bostrom revient sur le problème, évoqué au ch. 9, de la configuration des valeurs de la super-IA : « comment placer une valeur chez un agent artificiel de manière qu’il poursuive cette valeur en tant qu’objectif final ? ». L’auteur convient de la difficulté du sujet qui, chez les humains aussi, se heurte à des obstacles majeurs, vu le flou des définitions et les difficultés actuelles de formalisation. À la sortie du chapitre, après l’examen de quelques techniques possibles pour implanter ces valeurs, on n’est guère plus avancé qu’au début.

De toute façon, même en supposant résolu le problème précédent, un autre, plus fondamental, subsisterait : celui de savoir quelles valeurs il faudrait configurer. « En d’autres termes, résume Bostrom, que voudrions-nous qu’une super intelligence veuille ? ». C’est le sujet du chapitre 13, « Choisir les critères pour choisir ».

Les difficultés ne sont pas moindres que dans le cas précédent. Nick Bostrom semble considérer que notre capacité de jugement est trop faible pour nous permettre de traiter le sujet correctement, sans gros risque d’erreur. D’où l’idée de se limiter à la normativité indirecte : « n’ayant qu’une confiance limitée dans notre capacité à spécifier concrètement un standard de normes, nous spécifierions seulement des conditions plus abstraites, que tout standard de normes devrait satisfaire, dans l’espoir qu’une super intelligence puisse trouver un standard concret qui satisfasse à ces conditions ». Cette position est un peu surprenante : elle paraît contredire l’idée, omniprésente dans les chapitres précédents, que le contrôle de l’IA, et notamment celui de ses valeurs, est indispensable pour parer aux risques existentiels que la super-IA nous ferait courir. Si on délègue à l’IA son propre autocontrôle moral, que devient cette exigence ?

Le chapitre 14 traite de questions moins abstraites. Nick Bostrom y formule quelques recommandations sur les chemins à prendre en allant vers la super-IA.

Faut-il ou non promouvoir les recherches sur l’émulation du cerveau ? Bostrom est hésitant : d’un côté, la production de cerveaux émulés, intermédiaires entre le cerveau humain et la super-IA, pourrait faciliter la transition ultérieure vers la super-IA, la rendre moins brutale et limiter le risque existentiel qui en découle ; mais, d’un autre côté, la transition vers les cerveaux émulés n’est pas exempte elle-même de risques existentiels, qui s’ajouteraient à ceux de la super-IA.

D’autres recommandations sont plus banales, voire assez conformistes. Ainsi, il serait bon de favoriser la coopération entre les équipes de recherche pour limiter la dynamique de la concurrence qui, si elle est trop forte, pourrait se développer au détriment des ressources à consacrer au contrôle de l’IA. Nick Bostrom suggère enfin d’édicter une norme qu’il baptise « principe du bien commun » : « la super intelligence devrait être développée seulement pour le bénéfice de toute l’humanité et au service d’idéaux éthiques largement partagés ». Ce propos contraste avec le chapitre 13 où Bostrom, à l’opposé, souligne la difficulté pour l’être humain de définir des normes morales stables et incontestées.

L’énoncé d’orientations se poursuit au chapitre 15, qui conclut le livre. L’auteur n’évite pas non plus la banalité : développer l’analyse stratégique ; développer une base de ressources pour la recherche et l’analyse, avec un réseau de donateurs (en clair, « plus d’argent pour ma fondation ») ; faire des progrès sur les défis techniques de la sécurité en matière d’IA ; développer les bonnes pratiques chez les chercheurs en IA, etc.

Commentaires.

1 L’auteur ne semble pas douter de la future émergence de super intelligences, qu’elles soient artificielles ou biologiques. Cela paraît raisonnable, même si l’on reste incertain sur le calendrier. C’est conforme à ce que nous savons des processus de l’évolution physico-chimique (apparition et complexification des structures dites dissipatives) et de ceux de l’évolution biologique depuis des centaines de millions d’années. Nous procédons d’espèces humaines inférieures et d’espèces infra-humaines, moins intelligentes. Pourquoi n’engendrerions-nous pas d’autres organismes plus intelligents ?

2 La nouveauté est que cette gestation nouvelle serait ici, à la fois, voulue par nous (même si nous n’en maîtrisons pas les conséquences -mais c’est en fait un trait propre à toute action humaine) et, possiblement, bien plus rapide que l’évolution passée.

3 Cette problématique de la super intelligence semble ébranler les fondations de la philosophie des Lumières sur plusieurs points fondamentaux :

* la position centrale et éminente de l’Homme (notre espèce, Homo sapiens) : sans jeu de mots, la vision des Lumières est un peu celle des gens qui prêchent seulement pour leur paroisse (la Terre, et seulement la Terre d’aujourd’hui, et encore pas toute la Terre -en fait, le monde occidental) ; de même que, depuis Copernic, nous avons compris que la Terre n’est pas le centre de l’univers, pourquoi ne nous habituerions-nous pas à penser que l’homme n’est pas au centre du monde ? nous serions donc, plutôt, « un pont tendu entre la bête et le surhomme », selon la formule de Nietzsche (prologue à Ainsi parlait Zarathoustra) : un organisme supérieur par son intelligence aux autres animaux, mais très inférieur aux super intelligences ;

* l’unité du genre humain (et l’égalité fondamentale de ses membres) : sans même évoquer l’IA, les perspectives tracées par Nick Bostrom -sélection biologique d’individus plus intelligents, voire production d’hommes augmentés- promettent de ruiner cette idée ; on sent que Bostrom est gêné de l’admettre ; d’où sa norme dite « du bien commun », mais qu’il illustre par des exemples qui, en fait, reviennent à accepter, avec l’émergence des super intelligences, l’apparition d’inégalités très supérieures à celles que nous connaissons actuellement ;

* l’universalité des valeurs : comme le reconnaît Nick Bostrom, il est déjà illusoire d’identifier les valeurs qui seraient propres à notre espèce ; que dire alors des valeurs de la ou des super intelligences, si ce mot même de « valeurs » devait avoir un sens pour elles ?

4 Nick Bostrom n’est pas toujours très convaincant à propos des caractéristiques et du mode d’évolution de la super-IA. Ne privilégie-t-il pas de façon excessive le scénario : IA unique, à tendance monopolistique, présentant un risque existentiel pour les humains ?

D’abord, pourquoi une IA unique ? Peut-être, à la rigueur, sur la Terre, mais ailleurs ? Même avec une probabilité d’apparition d’une super-IA extrêmement faible, la taille de l’univers pourrait être suffisante pour que de nombreux autres cas se soient produits ou se produisent dans l’avenir. Si chacune de ces super-IA développe sa propre stratégie de colonisation, il paraît inévitable que leurs machines de Von Neumann finissent par se rencontrer. On se retrouverait alors placé dans une situation de concurrence entre IA, modélisable par des règles darwiniennes de sélection / conflit / coopération (l’évitement entre IA pouvant être une des formes de coopération). Les tendances monopolistiques des IA, à supposer qu’elles soient réelles, seraient ipso facto régulées.

Dans ce scénario, la réalité du risque existentiel devrait aussi être réexaminée : il serait étrange que nous n’ayons pas été déjà approchés ou envahis par une super-IA. Pourquoi cela ne semble-t-il pas être le cas ? Deux explications sont a priori possibles.

Ou bien, nous sommes encore seuls dans l’univers, celui-ci étant trop jeune pour que des naissances de super-IA se soient produites ailleurs (variante : de telles naissances se sont produites, mais lesdites IA n’ont pas encore eu le temps de parvenir jusqu’à nous).

Ou bien, pour maximiser son efficacité, la super-IA, une fois qu’elle est apparue, tend très rapidement à se miniaturiser et à alléger son support matériel dans des proportions défiant notre imagination : ce qui la rendrait imperceptible et indétectable avec nos instruments de mesure et d’observation actuels. Dans une telle hypothèse, en quasi-totalité, les IA existantes pourraient être parfaitement inoffensives à notre égard ; tout comme nos corps sont traversés en permanence par des myriades de particules qui ne nous font aucun mal.

- Traduction française en 2017, sous le titre Super intelligence, chez l’éditeur scientifique Dunod. ↩︎

- « Are you living in a computer simulation ? », Philosophical Quarterly, vol 53, No 211, 2003 (en ligne). ↩︎

- Tout cela évolue très vite : en 2017, le programme AlphaGo a battu le meilleur joueur de Go du monde. ↩︎

- Ici encore, de nouveaux domaines s’ajoutent sans cesse à ceux déjà révolutionnés par l’IA vers 2015 : par exemple la chimie, dont les capacités d’analyse s’accélèrent dans des proportions qui vont devenir colossales. ↩︎

- Par convention, pour comparer des quantités très grandes, on dit que la quantité A dépasse B de x ordres de grandeur quand A = B*(10x) ; 1 000 fois plus = supérieur de 3 ordres de grandeur. ↩︎

3 commentaires

Remarquable synthèse. Merci l’IRDEME

Your commentary is not tied to the review of the Bostrom’s book. Can you wite more ?

En fait cette technique algorithmique assortie de dépouillement statistique avec une pincée de probas se nomme abusivement « intelligence »

Les commentaires sont fermés.